- У яких випадках варто застосовувати скрапінг даних?

- Наш досвід роботи з веб-скрепінгом

- Захист від скрейпінгу та як ми його обійшли

- Використання ШІ для збору даних

- Традиційні сервіси веб-скрейпінгу проти рішень на основі ШІ

- Підсумок

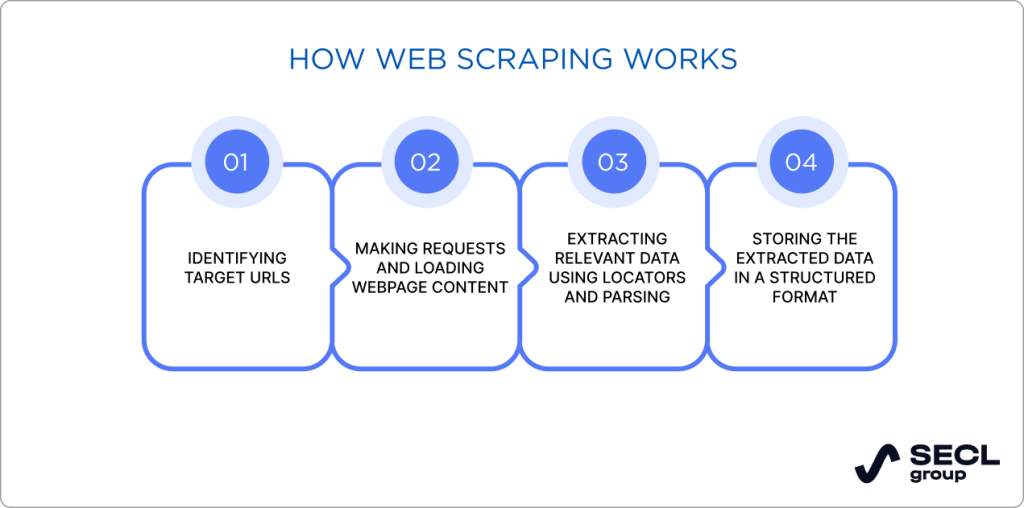

Скрапінг даних — це чудова можливість швидко наповнити ваш сайт або принаймні його частину контентом. Йдеться про процес отримання різноманітної інформації з вебсайтів, який зазвичай зосереджений на зборі конкретних типів даних, зокрема відомостей про товари, контактних даних тощо. Скрапінг може виконуватися за запитом або періодично — для отримання найбільш актуальної інформації. Як правило, послуги зі скрапінгу даних корисні для таких завдань, як моніторинг цін, агрегація контенту, аналіз тональності чи дослідження конкурентів. Після завершення зібрані результати можуть бути безпосередньо передані на сайт клієнта.

У яких випадках варто застосовувати скрапінг даних?

Скрапінг даних можна застосовувати в різних сферах, адже його кейси охоплюють чимало галузей — від електронної комерції й туризму до підбору персоналу та фінансів. Одним із найпоширеніших варіантів використання веб-скрейпінгу є моніторинг цін. Як правило, інтернет-магазини та сайти оголошень використовують динамічне ціноутворення, коли вартість товарів може змінюватися кілька разів на день, тож відстеження цих змін є критично важливим для збереження конкурентоспроможності. Онлайн-продавці можуть використовувати скрапінг вебданих, щоб залишатися в курсі коливань цін і своєчасно коригувати власну цінову політику.

Дослідження ринку – ще одна популярна сфера використання. Сервіси веб-скрейпінгу допомагають підприємствам проводити глибокий та релевантний аналіз ринку та трендів. Вони також можуть відстежувати настрої клієнтів, ринковий попит та підходи конкурентів. Крім того, компанії можуть підтримувати свою репутацію і шукати шляхи вдосконалення продуктів або послуг, вивчаючи відгуки та проблеми клієнтів. Вся ця цінна інформація може допомогти адаптувати маркетингові стратегії та приймати більш обґрунтовані стратегічні рішення.

Для сайтів нерухомості послуги веб-скрейпінгу є корисними для швидкої консолідації інформації. Ви можете отримувати дані та оголошення з кількох джерел і на їх основі формувати контент для власного вебсайту. Такий підхід дозволяє надавати більш детальну інформацію, ніж у конкурентів, і краще відповідати потребам клієнтів.

У фінансовому секторі веб-скрейпінг допомагає аналітикам відстежувати зміни в цінах на акції та сировинні товари. Це дозволяє їм прогнозувати майбутні зміни та реакцію ринку, що може впливати на вартість акцій і допомагати інвесторам ухвалювати вигідніші рішення. За допомогою сервісів веб-скрейпінгу ви можете збирати дані з різних джерел та аналізувати важливі економічні показники.

Послуги веб-скрейпінгу можна також використовувати для інших цілей і практично в будь-якій галузі, яку тільки можна уявити. Їх застосування доречне у будь-якій ситуації, коли необхідно зібрати й опрацювати великі обсяги даних без ручної обробки.

Наш досвід роботи з веб-скрепінгом

У SECL Group ми використовували веб-скрейпінг у низці проєктів і хочемо поділитися кількома прикладами, щоб продемонструвати наш досвід.

Перш за все, вебскрейпінг став надзвичайно корисним під час розробки з нуля порталу з нерухомості для одного з наших клієнтів. Вони звернулися до нас із завданням створити велику платформу для купівлі, продажу та оренди нерухомості. Проте на початковому етапі у них не було контенту для заповнення сайту.

Клієнт попросив нас розробити інструменти для збору даних з трьох найбільших веб-сайтів нерухомості. Ми отримали всі дані про об’єкти нерухомості, включно з описами, контактною інформацією, зображеннями тощо. Просто розмістивши ці оголошення на порталі, клієнт отримував десятки тисяч відвідувачів на місяць. Однак важливо зазначити, що на той час Google не мав таких суворих правил щодо унікальності контенту.

Ми також використовували веб-скрапінг під час розробки торговельного маркетплейсу для перепродажу товарів, вироблених у Китаї. Це був аналог Alibaba.com, і нам потрібно було наповнити сайт інформацією про товари. Для цього проєкту ми збирали дані з Taobao.com, зокрема назви товарів, описи, контактну інформацію продавців тощо. Потім ми переклали ці дані з китайської на мови країн, у яких працював маркетплейс, і використали їх на сайті. Таким чином сайт клієнта почав отримувати трафік із пошукових систем.

Ми також збирали інформацію за допомогою інструментів веб-скрапінгу для одного з наших фінтех-проєктів. Це була платформа для об’єднання комунальних платежів (газ, електроенергія, вода тощо) в єдину систему та оплати їх через цю систему. Це був стартап зі Сінгапуру, який працював у різних країнах Азії.

Ми збирали дані з різних урядових вебсайтів. Іноді цей процес був складним через використання застарілих технологій на цих вебсайтах, наприклад, багато урядових вебсайтів в Індії використовували такі застарілі технології. Попри це, нам вдалося отримати 90% необхідної інформації, тоді як на збір решти 10% знадобилося б занадто багато часу. Клієнт вирішив, що на тому етапі було б нерозумно продовжувати збір решти 10%.

Захист від скрейпінгу та як ми його обійшли

Також важливо згадати, як ми обходили різні рівні захисту від скрапінгу на різних сайтах. По-перше, потрібно мати на увазі, що складність такого захисту залежить від розміру та популярності сайту. Наприклад, невеликі сайти рідко використовують складні багаторівневі механізми захисту, на відміну від гігантів на кшталт Amazon чи Taobao. Зрештою, нам знадобилося кілька місяців, щоб обійти захист від скрапінгу, перш ніж ми виконали завдання.

Насамперед, будь-яка нелюдиноподібна взаємодія з вебсайтом викликає підозру. Це стосується занадто швидкого переходу між сторінками, великої кількості запитів від одного користувача тощо. Як правило, боти переглядають сторінки з дуже високою швидкістю або здійснюють багато взаємодій, які людина ніколи не змогла б зробити за короткий час.

Деякі вебсайти також використовують динамічне відображення контенту для завантаження свого вмісту за допомогою JS або AJAX. Це означає, що дані недоступні у вихідному коді HTML-сторінки. Натомість вони генеруються у процесі завантаження сторінки браузером або сервером. Це ускладнює збір даних для скрейпінгу. Щоб отримати повну інформацію зі сторінок, їм потрібно виконати код JavaScript або зробити більшу кількість запитів.

Крім того, власники сайтів можуть змінювати назви полів у коді, щоб вони не відповідали умовам для скрапінгу. Таким чином, скрапери не можуть знайти потрібну інформацію, тоді як для звичайного користувача нічого не змінюється. Іноді вебсайти використовують рандомізовані модифікації, щоб різними способами переривати робочий процес ботів. Ось чому вам потрібно постійно вдосконалювати та підтримувати свої скрипти, над чим ми працюємо у всіх наших проєктах. Ви також повинні постійно перевіряти дані, отримані з вебсайту, та завантажувати їх лише тоді, коли вони є коректними.

На щастя, майже всі сучасні рішення для веб-скрейпінгу мають функції, призначені для уникнення блокування або обходу захисних механізмів, про які ми згадували вище. Ось типові методи обходу антискрейпінгових інструментів, які ми застосовуємо у своїх проєктах:

- уповільнення роботи скрипта, щоб він проводив більше часу на одній сторінці;

- використання технік розпізнавання CAPTCHA для автоматизованого розв’язання завдань;

- застосування проксі з різних регіонів, щоб уникнути блокування на основі геолокації;

- використання пулу IP-адрес для розподілу запитів та запобігання блокуванню IP;

- додавання рандомізованих запитів для імітації поведінки людини.

Важливо також проаналізувати сайти, з яких ви плануєте отримувати дані, і з’ясувати, які типи захисту від скрейпінгу на них використовуються. Чим більший і складніший сайт, тим більш досконале рішення для скрейпінгу вам знадобиться для успішного збору даних. Необхідно постійно відстежувати появу нових методів захисту та підтримувати високу якість отриманої інформації.

Як правило, рішення для веб-скрепінгу створюються за допомогою Python. Ця мова програмування є найпопулярнішою для таких задач, оскільки має якісні бібліотеки, що дозволяють швидко отримувати дані. Іноді для обходу захистів також використовуються певні бібліотеки JS. У нашій статті ми не будемо заглиблюватися в технічні аспекти роботи сервісу веб-скрепінгу. Однак ви можете звернутися до нас, якщо вам потрібна допомога у вилученні великих обсягів даних.

Якщо ви хочете створити рішення для скрейпінгу на Python, ми можемо вам допомогти

Зв’яжіться з нашою командою, щоб обговорити деталі.

Використання ШІ для збору даних

Традиційний веб-скрепінг надзвичайно корисний. Без нього довелося б витрачати значно більше часу на ручний збір даних. Водночас цей підхід має певні обмеження, а алгоритми штучного інтелекту та машинного навчання змінюють процес збору даних, роблячи його більш ефективним і масштабованим.

Збір даних на основі штучного інтелекту робить процес скрейпінгу значно ефективнішим. Зазвичай, ШІ вже знає інформацію, яку потрібно зібрати, і може згенерувати її дуже швидко. В інших випадках ви можете написати запит для інструменту на основі ШІ, щоб знайти та згрупувати необхідну інформацію. Як правило, перший варіант є більш поширеним і може бути легко доданий через інтеграцію API зі штучним інтелектом, який має велику базу даних.

Використання ШІ для веб-скрейпінгу — це альтернативний підхід, який має чимало переваг. Інструменти на базі ШІ не витягують дані з одного конкретного сайту, а збирають їх з усього інтернету та подають в уніфікованому форматі. Наприклад, ви можете зібрати характеристики товарів або відгуки, а потім перекласти їх іншою мовою для проведення порівняльного аналізу.

Ми використовуємо штучний інтелект у сервісах зі скрапінгу вебданих для туристичного стартапу, з яким працюємо, і який має комплексну платформу для планування подорожей. Платформа має бути дуже інформативною, оскільки вона охоплює різні аспекти даних і планування подорожей – від цін до погоди та напрямків. У цьому проєкті вебскрейпінг на основі штучного інтелекту допомагає нам отримувати точну інформацію щодо таких великих обсягів даних.

Нещодавно ми працювали над розробкою завдань, що моніторять ціни на готелі та оренду квартир, температуру повітря та води щомісяця, а також знаходять безпечні райони для проживання в місті чи країні. Наприклад, ми отримуємо дані з Booking.com для моніторингу цін на готельні бронювання та з AirBnb.com для оренди квартир. Ми також скрейпимо інші сайти, такі як Vrbo або Tripadvisor rentals для країн, де попередні два сервіси не так популярні. І це все стосується лише одного аспекту туристичного сайту, над яким ми працюємо.

У результаті ШІ допоміг надати достовірні дані про середньомісячну температуру води та повітря в різних локаціях. Це було надзвичайно економно, адже інтеграція зайняла всього кілька днів замість місяців.

Однак у деяких випадках сервіси веб-скрейпінгу на базі ШІ не змогли повністю замінити традиційні методи. Наприклад, генерувати середні ціни на житло було складно, оскільки ШІ надавав непослідовні результати. У підсумку ми використали ШІ-рішення більш ніж для десятка завдань у цьому проєкті. Це допомогло заощадити кілька тисяч доларів. Зрештою ми поєднали традиційні й ШІ-інструменти для виконання різних завдань.

Вибір найкращого рішення на основі штучного інтелекту також є важливим. Існують різні типи штучного інтелекту, кожен із яких має свої особливості, переваги та недоліки. Ви можете обрати між ChatGPT, Gemini, Jasper, QuillBot та менш популярними інструментами. Вам також потрібні детальні запити та досвідчений оператор ШІ, який знає, як писати запити для отримання точних даних.

Традиційні сервіси веб-скрейпінгу проти рішень на основі ШІ

Коли йдеться про вибір оптимального методу веб-скрейпінгу, все сильно залежить від конкретного проєкту. Обидва підходи мають свої переваги, недоліки та сфери застосування. У цій частині статті розглянемо їх докладніше.

З одного боку, традиційний веб-скрейпінг легко налаштовується для простих сайтів і працює швидко та ефективно на статичних і добре структурованих ресурсах. Однак він вимагає більшої підтримки там, де є структурні зміни і має дуже обмежене розуміння контексту чи змісту інформації.

З іншого боку, веб-скрейпінг на основі ШІ більш стійкий до змін у структурі вебсайтів, мінімізує потребу в ручному втручанні та обслуговуванні завдяки здатності до самонавчання, і може розуміти інформацію в контексті. Проте для ефективного і безпомилкового збору даних можуть знадобитися фахівці з поглибленими знаннями в галузі машинного навчання та обробки природної мови (NLP).

Як правило, API на основі штучного інтелекту надають платні послуги. Оскільки ми генеруємо дані за їх допомогою лише один раз, це залишається доступним варіантом. У деяких випадках вам знадобиться лише кілька сотень доларів, щоб отримати необхідну інформацію. Створення інструменту для скрейпінгу з нуля, його оновлення та підтримка потребуватимуть значно більших інвестицій. Обслуговування API на основі ШІ також є простішим, оскільки вам потрібно лише змінювати запит і місця для зберігання даних у базах даних.

Вибираючи відповідні сервіси для веб-скрепінгу, необхідно проконсультуватися з досвідченою командою, яка допоможе вам визначитися з найкращим технологічним стеком, знайти способи обходу захисту від ботів і визначити найбільш економічно ефективні рішення для ваших потреб.

Підсумок

Сьогодні бізнесу набагато складніше досягти успіху без доступу до інформації з великої кількості джерел.

Веб-скрейпінг дозволяє збирати великі обсяги даних для подальшого використання чи аналізу. Він має широкий спектр застосувань, і іноді це єдиний спосіб так швидко отримати стільки інформації. Ми використовували його для наших проєктів електронної комерції, головним чином для маркетплейсів та систем корпоративного рівня.

Як альтернатива традиційному скрейпінгу, інструменти на базі штучного інтелекту допомагають заощадити час і кошти. Однак наразі ШІ ще не здатен повністю замінити цей процес, хоча з кожним днем наближається до цього все більше.

Якщо ви шукаєте досвідчених постачальників послуг веб-скрейпінгу, які також використовують інструменти на базі штучного інтелекту, не соромтеся звертатися до нас.